A indústria de Inteligência Artificial evoluiu em vários aspectos desde seu boom inicial em 2022 e, atualmente, testemunha uma grande mudança em direção à computação agente. E isso é impulsionado por aplicativos/wrappers construídos em modelos de ponta.

Ao mesmo tempo, para provedores de infraestrutura como a NVIDIA, tornou-se cada vez mais importante ter ampla largura de banda de memória e desempenho integrados. O objetivo é atender aos requisitos de latência das estruturas de computação agente, e com o Blackwell Ultra, o time verde conseguiu exatamente isso.

Por isso, em uma nova publicação no blog, a NVIDIA testou o Blackwell Ultra no InferenceMAX da SemiAnalysis, e os resultados são impressionantes.

Considerando que o Blackwell Ultra está atualmente em processo de integração com hiperescaladores, estes estão entre os primeiros benchmarks da arquitetura. E, ao que tudo indica, a NVIDIA conseguiu manter a escalabilidade de desempenho intacta e alinhada aos casos de uso de Inteligência Artificial modernos.

Com Vera Rubin, pode-se esperar um desempenho ainda superior da geração Blackwell, tornando-a uma das muitas razões pelas quais a NVIDIA domina atualmente a corrida da infraestrutura.

Notícias Relacionadas:

- Colorful anuncia novos notebooks gamer Evol P15 com CPUs Intel e GPUs RTX 50

- NVIDIA adiciona 8 jogos ao GeForce Now nesta semana – confira!

- Novo dispositivo da Aqua Computer tenta resolver o problema do conector 16-pin que derrete em GPUs

Relação custo benefício

O primeiro infográfico da NVIDIA destaca um número chamado “token/watt”, um dos números mais importantes a serem observados no atual cenário de expansão da infraestrutura de hiperescala.

Nos testes, a empresa se concentrou tanto no desempenho bruto quanto nas otimizações de throughput. É por isso que, com o GB300 NVL72, a NVIDIA observa um aumento de 50 vezes no throughput por megawatt em comparação com as GPUs Hopper.

E a comparação mostra o melhor “estado de implantação” possível para cada arquitetura.

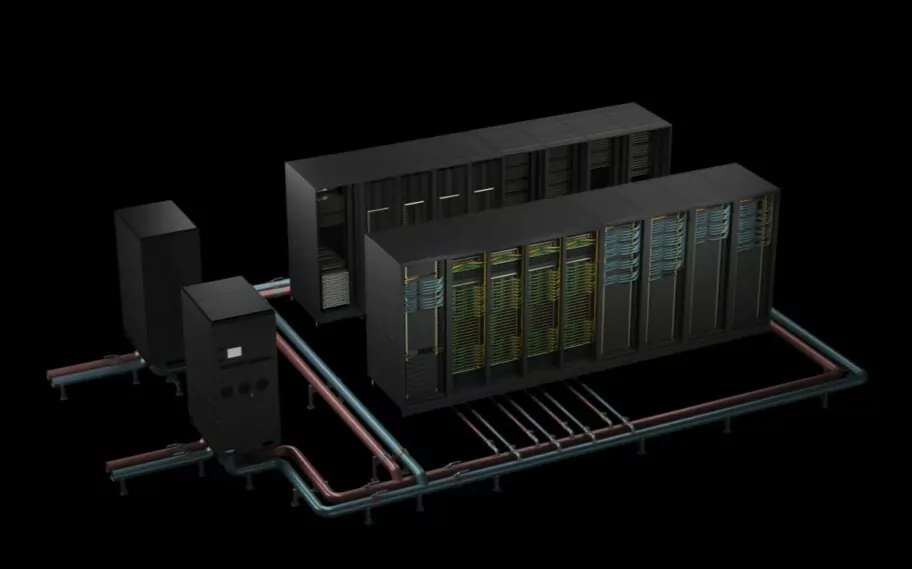

Para os curiosos de como os ganhos de throughput por megawatt são tão fenomenais, basta recordar que a NVIDIA se orgulha de sua tecnologia NVLink. O Blackwell Ultra expandiu para uma interface com 72 GPUs, unindo-as em uma única estrutura NVLink unificada com conectividade de 130 TB/s.

Comparado ao Hopper, que se limita a um design NVLink de 8 chips, a NVIDIA trouxe uma arquitetura superior, um design de rack otimizado e, mais importante, o formato de precisão NVFP4. Por essa razão, o GB300 domina em termos de throughput.

Custos dos Tokens

Considerando a onda de agentes de IA, os testes do GB300 NVL72 da NVIDIA também se concentram nos custos dos tokens e nas atualizações mencionadas. A equipe da NVIDIA observa uma redução massiva de 35 vezes no custo por milhão de tokens, tornando-o a opção de inferência ideal para laboratórios de ponta e hiperescaladores.

Mais uma vez, as leis de escalabilidade permanecem intactas e estão evoluindo a um ritmo inimaginável. E os principais catalisadores para essas melhorias de desempenho são, de fato, a estrutura de “design colaborativo extremo” implementada pela NVIDIA, juntamente com o que chamam de Lei de Huang.

A comparação com o Hopper torna-se um pouco injusta quando se consideram as diferenças incrementais nos nós de computação e arquiteturas. Por isso, a NVIDIA também comparou o GB200 com o GB300 (NVL72s) em cargas de trabalho de contexto longo.

O contexto é, de fato, uma grande restrição para agentes, já que manter o estado de toda a base de código exige o uso agressivo de tokens. Com o Blackwell Ultra, a NVIDIA observa um custo por token até 1,5 vezes menor e um processamento de atenção 2 vezes mais rápido, o que o posiciona bem para cargas de trabalho com agentes.

Fonte: NVIDIA.